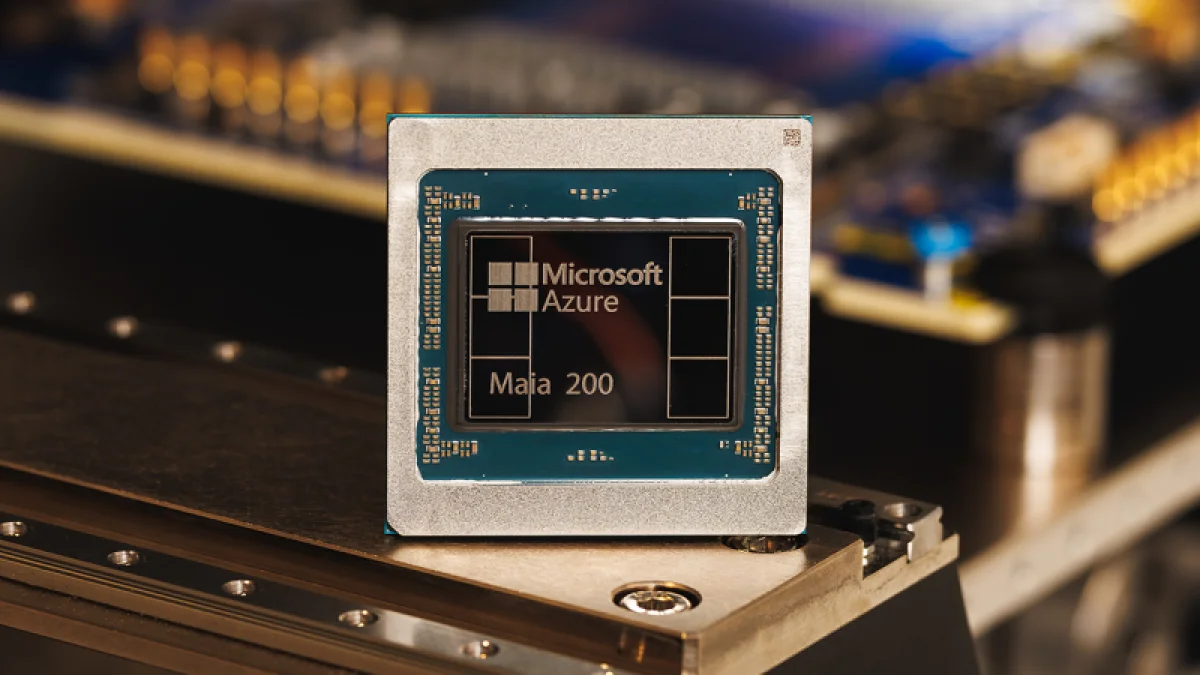

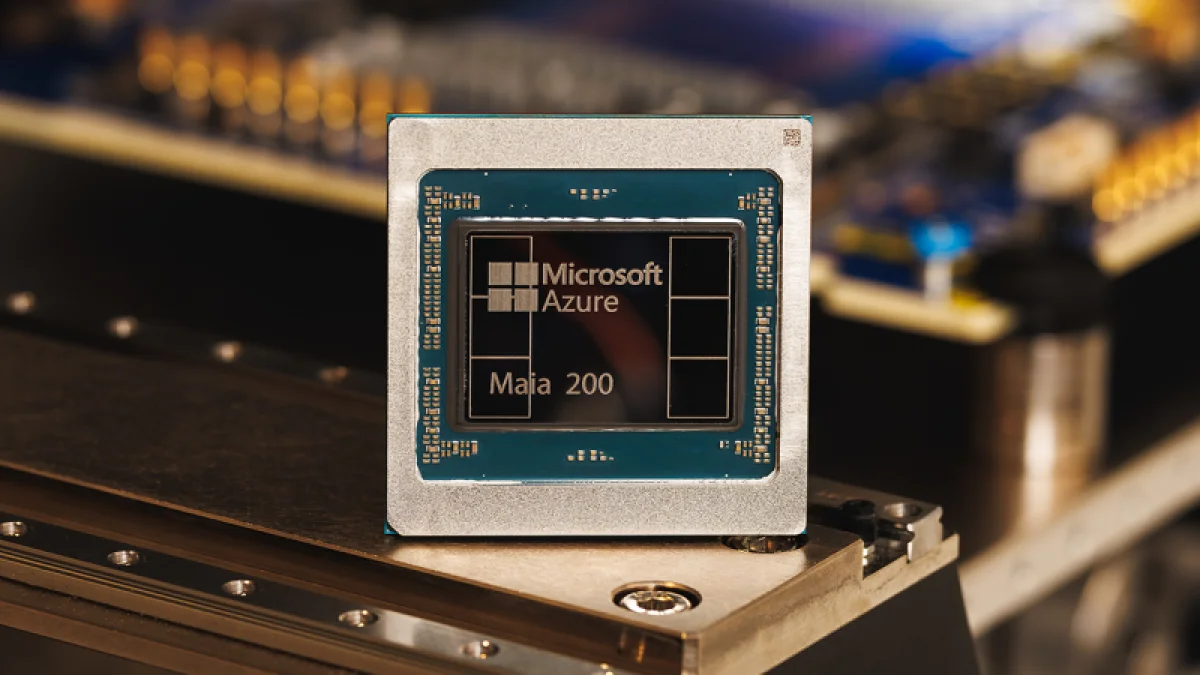

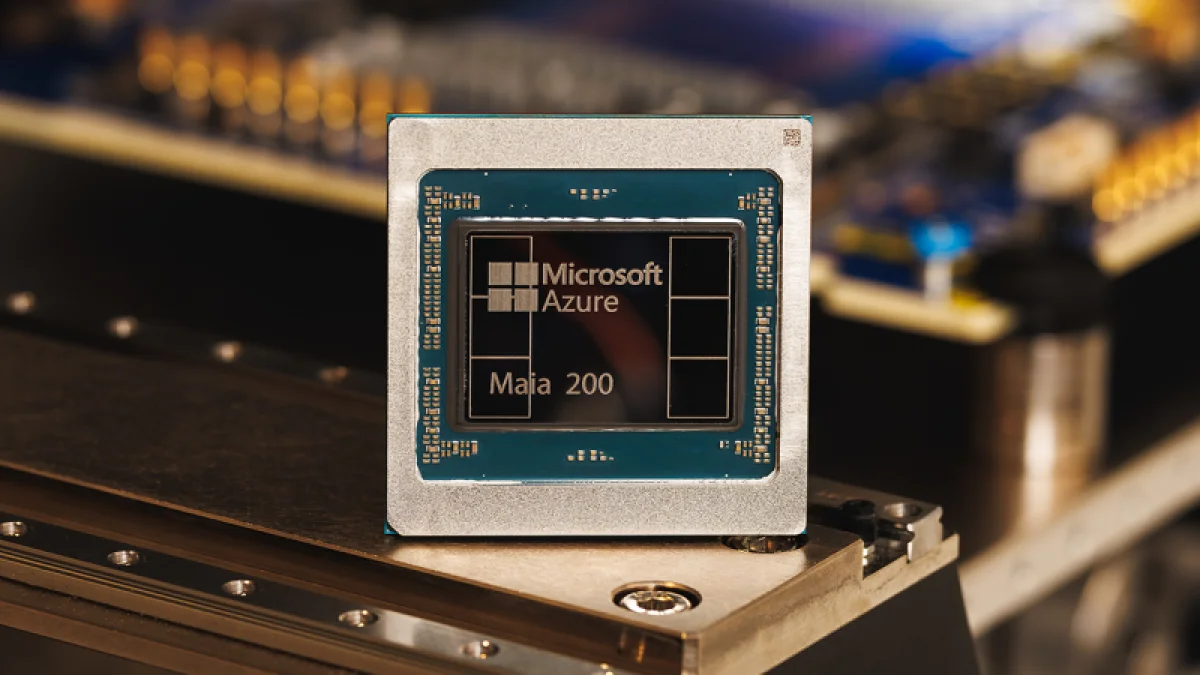

Компания Microsoft анонсировала 3-нанометровый ИИ-ускоритель Maia 200, предназначенный для инференса. Он оснащён специализированными тензорными ядрами с поддержкой форматов FP8 и FP4, усовершенствованной подсистемой памяти, включающей 216 ГБ HBM3e (пропускная способность 7 ТБ/с) и 272 МБ SRAM, а также DMA-движком, оптимизированной сетью на кристалле (NOC) и «механизмами передачи данных, которые обеспечивают быстрое и эффективное выполнение крупномасштабных моделей». Количество транзисторов в Maia 200 превышает 140 миллиардов.

Его производительность в формате FP4 составляет свыше 10 петафлопс, что примерно в три раза выше, чем у решения Amazon Trainium3, но почти вдвое ниже, чем у архитектуры NVIDIA Blackwell. В вычислениях FP8 показатель превышает 5 петафлопс, немного опережая Google TPU v7 Ironwood и снова отставая от Blackwell примерно в два раза. Тепловыделение (TDP) чипа достигает 750 Вт, а для его охлаждения применяется система жидкостного охлаждения (СЖО) и фирменные теплообменники второго поколения.

![Источник изображений: Microsoft]()

Источник изображений: Microsoft

На системном уровне в Maia 200 используется двухуровневая унифицированная сетевая фабрика, основанная на стандартном Ethernet. Специальный транспортный протокол Maia AI, применяемый как для вертикального, так и для горизонтального масштабирования, в сочетании с тесно интегрированным сетевым адаптером обеспечивают высокую производительность, надёжность и экономическую эффективность без необходимости в проприетарных интерконнектах. Каждый акселератор обладает выделенным интерфейсом с дуплексной пропускной способностью 2,8 ТБ/с. Заявлена возможность предсказуемых и высокопроизводительных коллективных операций в кластерах, объединяющих до 6144 ускорителей. Внутри каждого вычислительного узла четыре чипа Maia 200 взаимодействуют между собой напрямую, без использования коммутатора.

![]()

«Система Maia 200 также демонстрирует наивысшую эффективность в выполнении задач искусственного интеллекта среди всех решений, когда-либо внедрявшихся Microsoft, предлагая на 30 % более выгодное соотношение производительности к стоимости по сравнению с самым современным оборудованием в нашем парке», — заявили в компании. На данный момент Maia 200 уже функционирует в регионе US Central неподалёку от Де-Мойна (штат Айова), а в перспективе новые ускорители планируется развернуть в регионе US West 3, около Финикса (штат Аризона).

Корпорация также анонсировала предварительный выпуск комплекта разработки (SDK) для Maia, который содержит полный набор инструментов для создания и оптимизации больших языковых моделей под платформу Maia 200. В него входит широкий спектр функций, включая интеграцию с PyTorch, компилятор Triton, оптимизированную библиотеку ядер, а также возможность низкоуровневого программирования для Maia.

![]()

По информации от Microsoft, Maia 200 станет частью её гетерогенной инфраструктуры ИИ для работы с разнообразными моделями, в том числе с GPT-5.2 от OpenAI, что обеспечит экономическую эффективность для сервисов Microsoft Foundry и Microsoft 365 Copilot. Группа Microsoft Superintelligence будет применять Maia 200 для создания синтетических данных и обучения с подкреплением с целью совершенствования собственных моделей нового поколения. В рамках процессов синтетического конвейера данных использование Maia 200 позволит ускорить генерацию и отбор высококачественных данных, адаптированных под конкретные предметные области.

Источник: