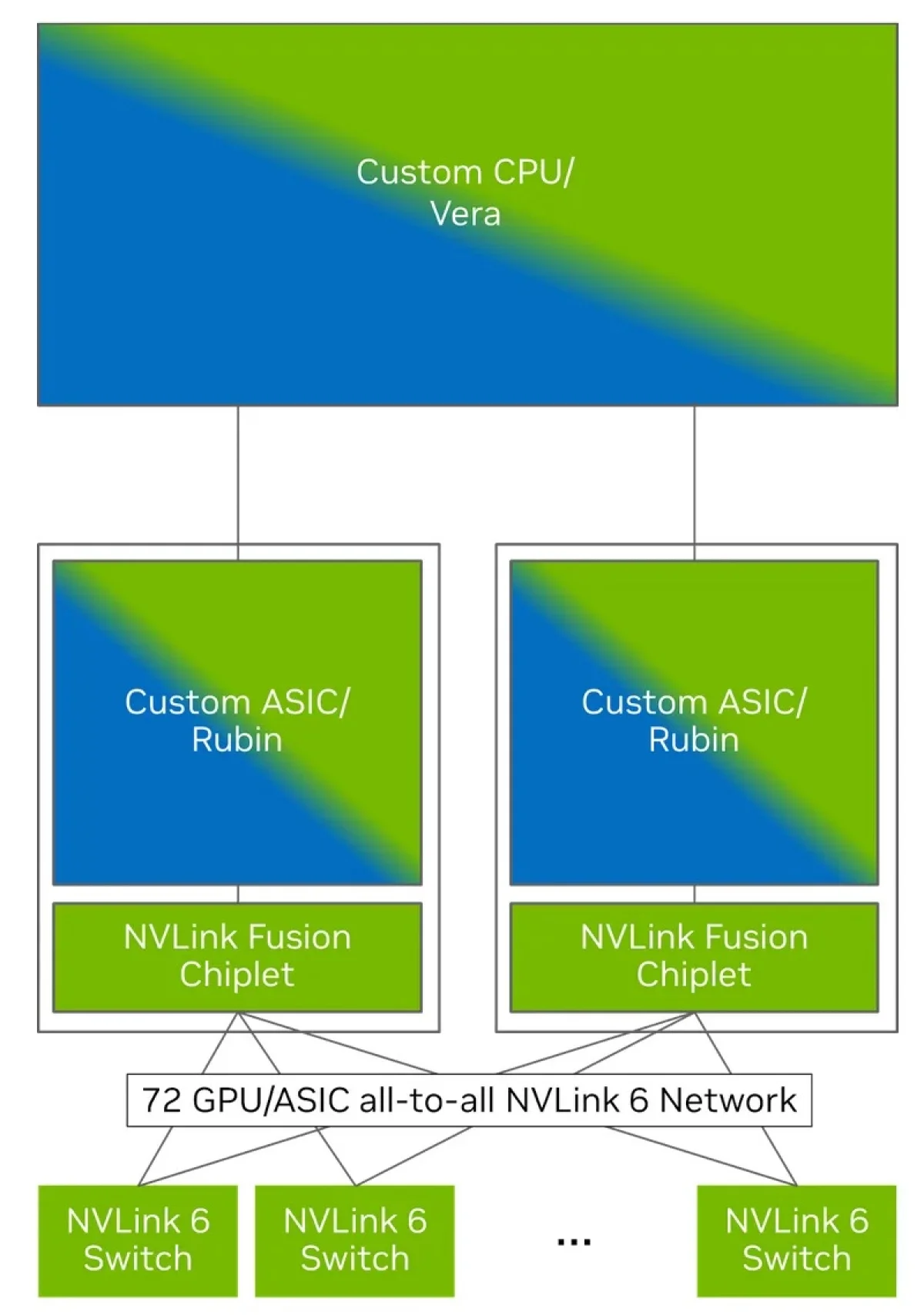

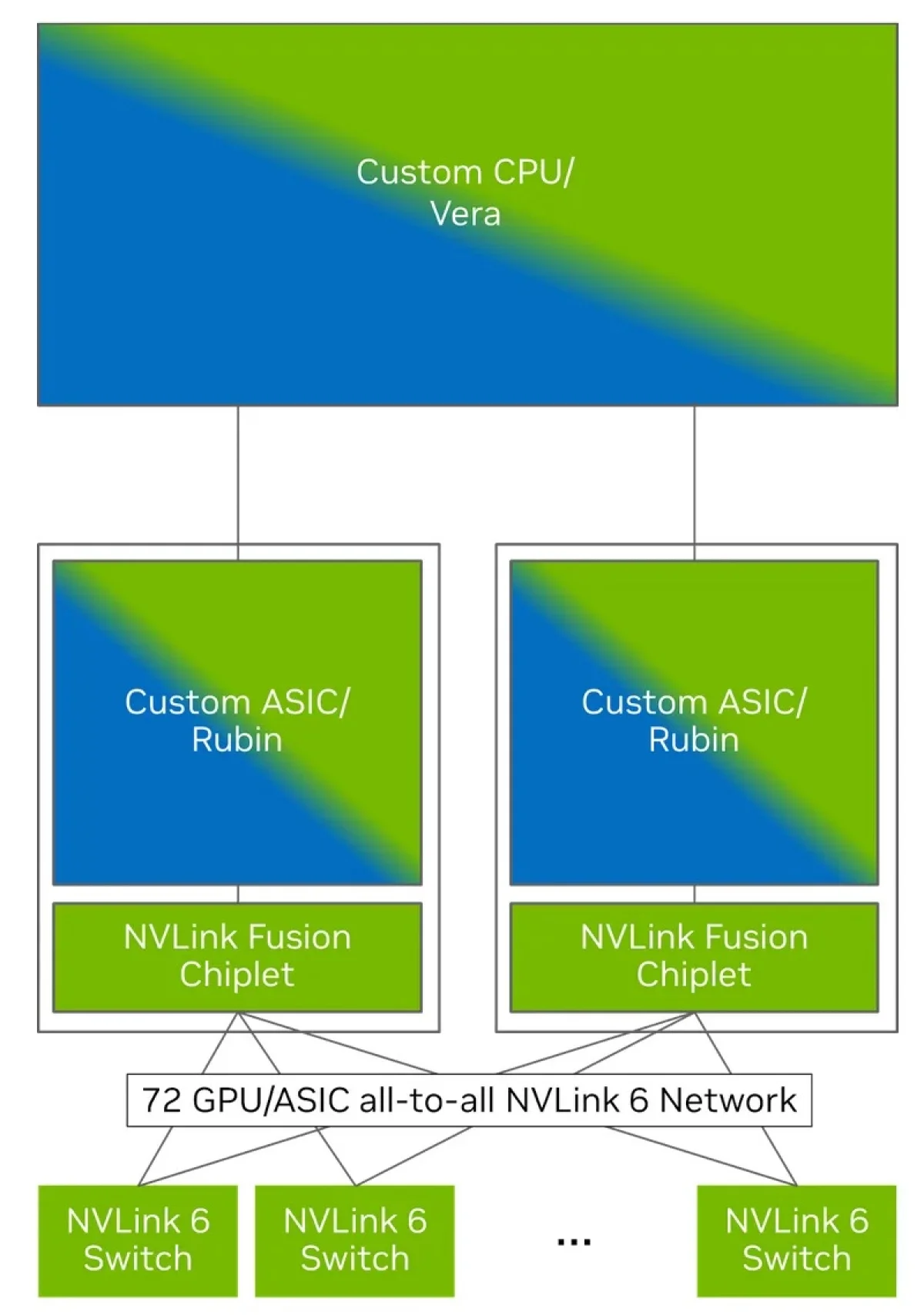

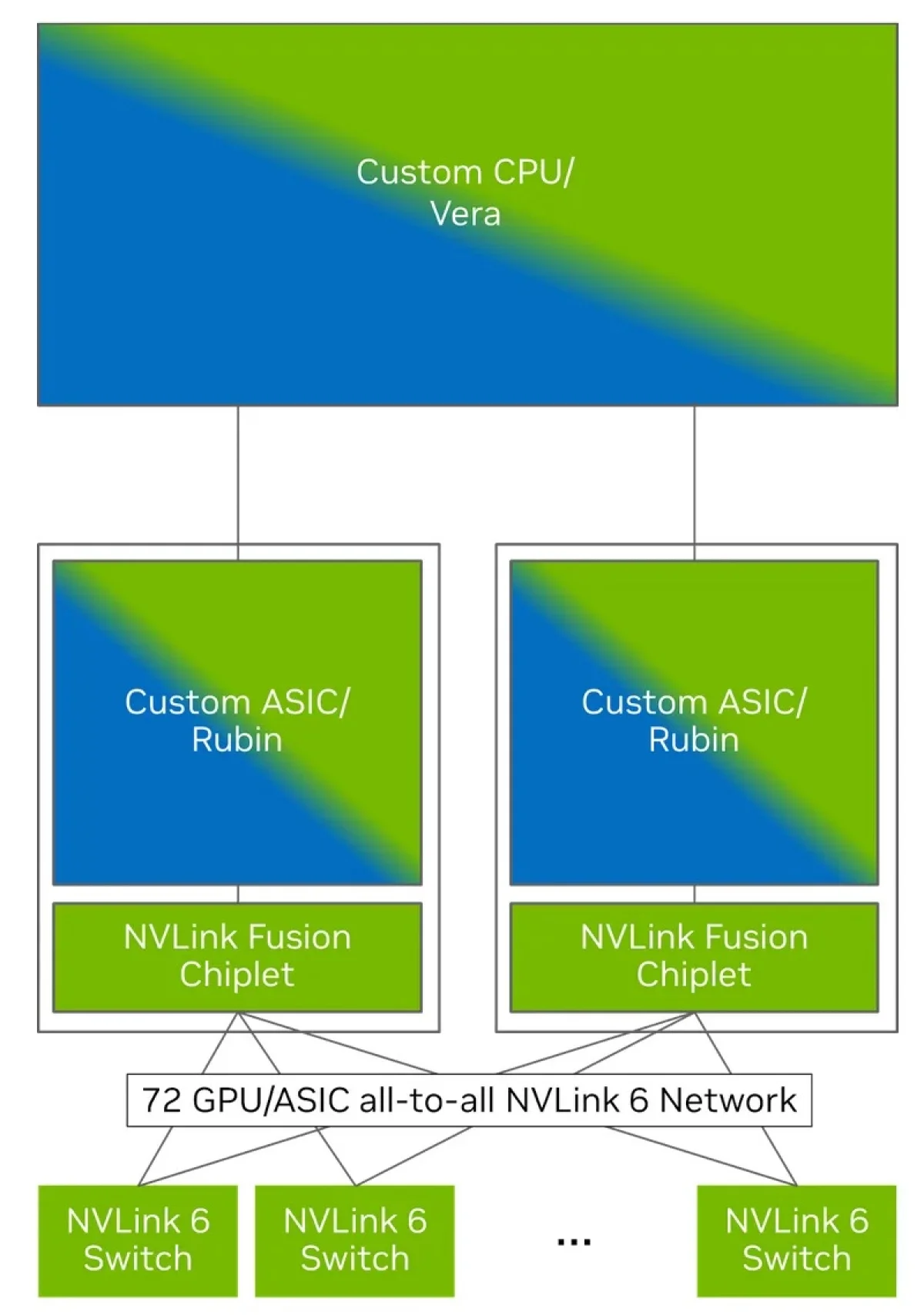

AWS разрабатывает процессоры Graviton5 на архитектуре Arm, которые будут работать в паре с ИИ-ускорителями Trainium4, оснащёнными интерконнектом NVLink Fusion, фирменными адаптерами EFA и DPU Nitro 6 с движком Nitro Isolation Engine. Ключевым же моментом является то, что всё это оборудование будет размещаться в стойках формата NVIDIA MGX.

Amazon и NVIDIA сообщили о стратегическом сотрудничестве, в результате которого ускорители Trainium4 получат шину NVLink Fusion шестого поколения от NVIDIA (предположительно, с дуплексной пропускной способностью 3,6 ТБ/с). Это позволит создать стоечную платформу следующего поколения, что примечательно, на основе архитектуры NVIDIA MGX, переданной в Open Compute Project (OCP). Интересно, что AWS долгое время практически не участвовала в OCP, самостоятельно разрабатывая стойки, их компоненты, включая системы охлаждения, и общую архитектуру дата-центров для ИИ. Даже в текущем поколении стоек с GB300 NVL72 компания не стала использовать референсный дизайн от NVIDIA.

NVIDIA, в свою очередь, подчёркивает, что для крупнейших облачных провайдеров создание собственных решений сопряжено со значительными трудностями — циклы разработки стоечной архитектуры очень длительны. Помимо проектирования специализированных ИИ-чипов, им необходимо решать задачи вертикального и горизонтального масштабирования, организации интерконнектов, систем хранения, а также прорабатывать саму конструкцию стойки, включая лотки, охлаждение, электропитание и программное обеспечение.

![Источник изображения: NVIDIA]()

Источник изображения: NVIDIA

Кроме того, управление цепочками поставок является крайне сложным процессом, поскольку требует скоординированной работы десятков поставщиков, отвечающих за десятки тысяч компонентов. Даже единичная задержка поставки или замена одной детали способны поставить под угрозу реализацию всего проекта. Платформа NVIDIA если и не решает эти проблемы полностью, то, по крайней мере, смягчает их, предлагая готовые стандартизированные решения, которые могут поставляться множеством рыночных игроков.

![Источник изображения: NVIDIA]()

Источник изображения: NVIDIA

Согласно заявлению NVIDIA, технология NVLink представляет собой уже проверенное и широко внедрённое решение, что отличает её от альтернативных методов масштабирования сетей. Применяемая совместно с собственным программным обеспечением компании, система NVLink Switch способна утроить производительность и экономическую отдачу от процессов AI-инференса, формируя единый домен из 72 ускорителей. Как отмечает NVIDIA, клиенты, выбравшие NVLink Fusion, получают возможность гибко использовать ресурсы платформы — каждый её элемент позволяет оперативно наращивать мощности для ресурсоёмких задач инференса и обучения агентных AI-моделей.

Что касается ускорителей Trainium4, то их производительность в операциях с точностью FP4 обещает быть в шесть раз выше, чем у Trainium3, а при работе с FP8 — в три раза. Пропускная способность памяти также возрастёт в четыре раза. Тем не менее, на текущем этапе собственные разработки Amazon не всегда способны на равных конкурировать с решениями от NVIDIA.

Источник: