Компания Nebius (ранее — головная организация «Яндекса») анонсировала платформу Nebius Token Factory для выполнения выводов ИИ: она даёт возможность масштабно развёртывать и настраивать открытые и адаптированные модели искусственного интеллекта, гарантируя высокую надёжность и требуемый уровень контроля.

По словам Nebius, использование проприетарных ИИ-моделей может вызывать сложности при расширении. В то же время, открытые и настраиваемые модели помогают преодолеть эти барьеры, однако их администрирование и защита по-прежнему остаются технически сложными и затратными для большинства разработчиков. Nebius Token Factory разработана для устранения этих недостатков: она объединяет адаптивность открытых решений с управляемостью, скоростью работы и экономической эффективностью, которые требуются компаниям для внедрения крупных ИИ-проектов.

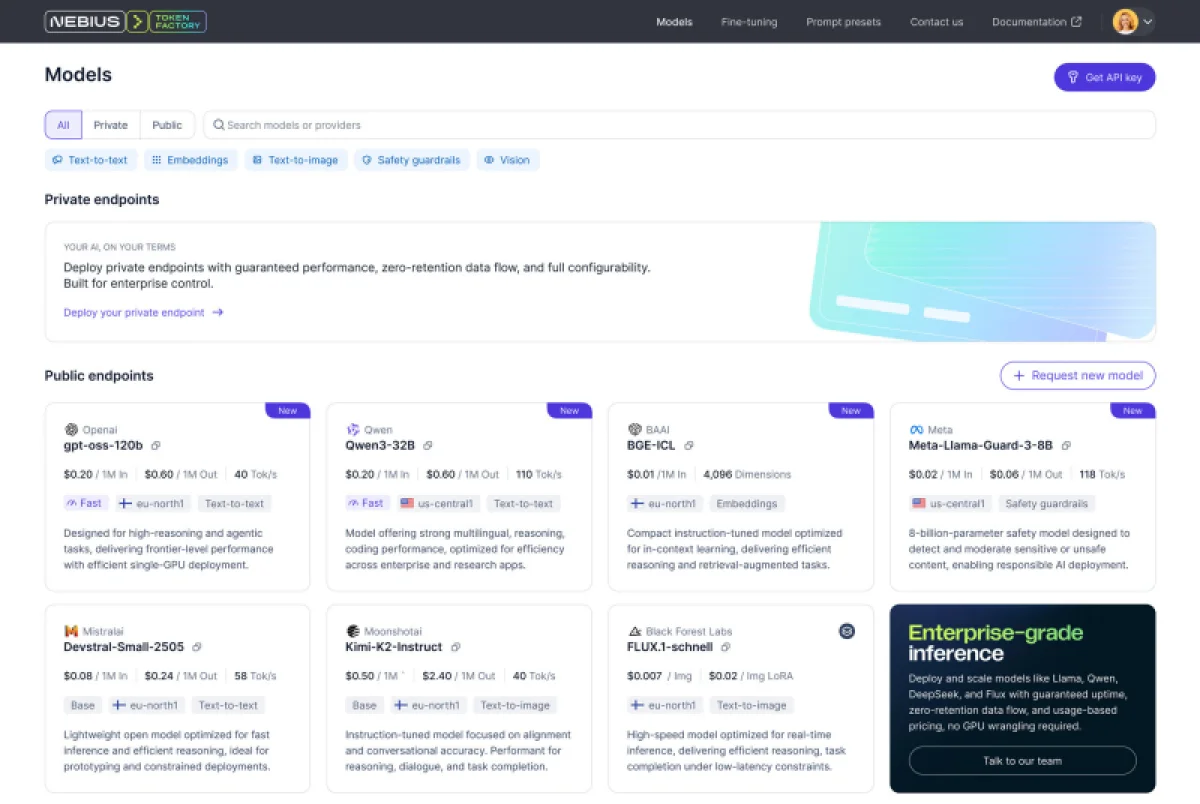

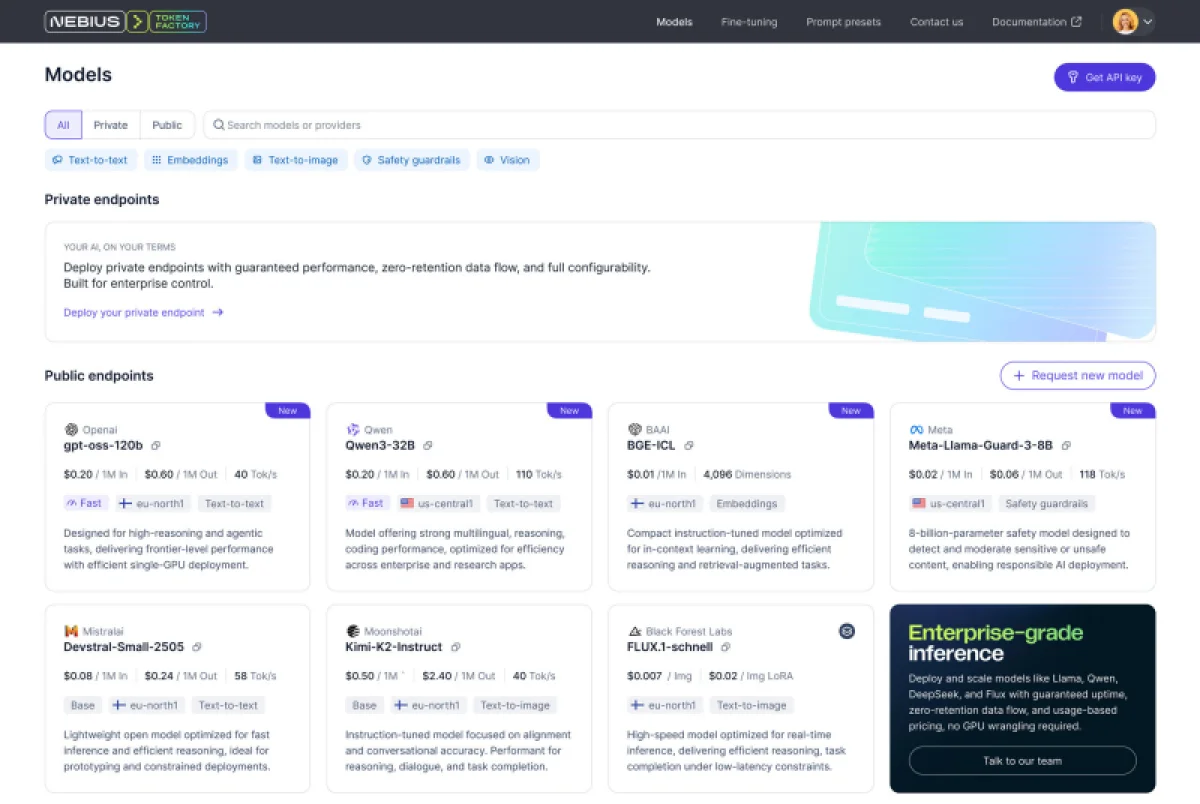

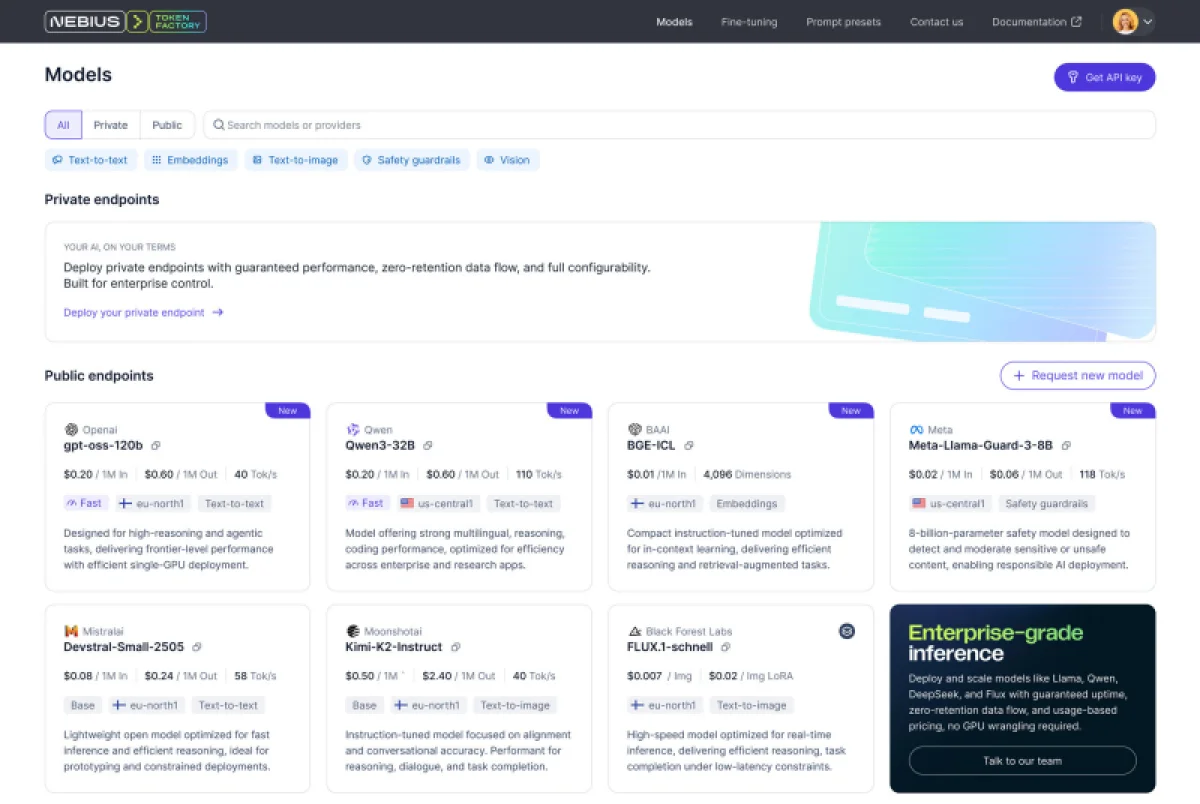

Nebius Token Factory построена на комплексной ИИ-инфраструктуре Nebius. Данная платформа интегрирует высокоскоростной вывод, дообучение моделей и регулирование доступа. Поддерживается свыше 40 моделей с открытым кодом, в том числе последние релизы Deep Seek, Llama, OpenAI и Qwen.

Источник изображения: Nebius

К основным достоинствам Nebius Token Factory относятся соответствие стандартам корпоративной защиты (HIPAA, ISO 27001 и ISO 27799), стабильная задержка (ниже 1 секунды), автономное масштабирование пропускной способности и доступность на уровне 99,9 %. Вывод данных осуществляется в дата-центрах Европы и США без хранения информации на серверах Nebius. Используется облачная среда Nebius AI Cloud 3.0 Aether, что, по заверениям, гарантирует безопасность корпоративного класса, активный мониторинг и устойчивую производительность.

Указывается, что Nebius Token Factory способна решать разнообразные задачи искусственного интеллекта: от умных чат-ботов, ассистентов по программированию и генерации с расширенным поиском (RAG) до скоростного поиска, обработки документов и автоматизированного клиентского сервиса. Встроенные средства точной настройки и сжатия моделей дают возможность предприятиям приспосабливать крупные открытые модели под свои информационные массивы. Это позволяет снизить расходы на вывод моделей до 70%. Оптимизированные версии затем можно оперативно запускать без необходимости ручной конфигурации инфраструктуры.

Первоисточник: