Компания Google сообщила о скором запуске ИИ-ускорителей седьмого поколения TPU v7 Ironwood, созданных для решения наиболее сложных задач: от масштабного обучения моделей и продвинутого обучения с подкреплением (RL) до высокоскоростного ИИ-вывода и обслуживания моделей с минимальными задержками.

В Google подчеркнули, что современные передовые ИИ-системы, такие как Gemini, Veo, Imagen от Google и Claude от Anthropic, обучаются и функционируют на базе TPU. Множество организаций переключают внимание с обучения моделей на обеспечение эффективного и отзывчивого взаимодействия с ними. Динамично меняющаяся архитектура моделей, расширение агентных процессов и почти экспоненциальный рост потребностей в вычислениях формируют новую эпоху инференса.

В частности, ИИ-агенты, которым необходима координация между универсальными вычислениями и ускорением машинного обучения, открывают перспективы для создания специализированных процессоров и оптимизированных системных архитектур. TPU Ironwood предназначен для расширения возможностей в области инференса и агентных задач.

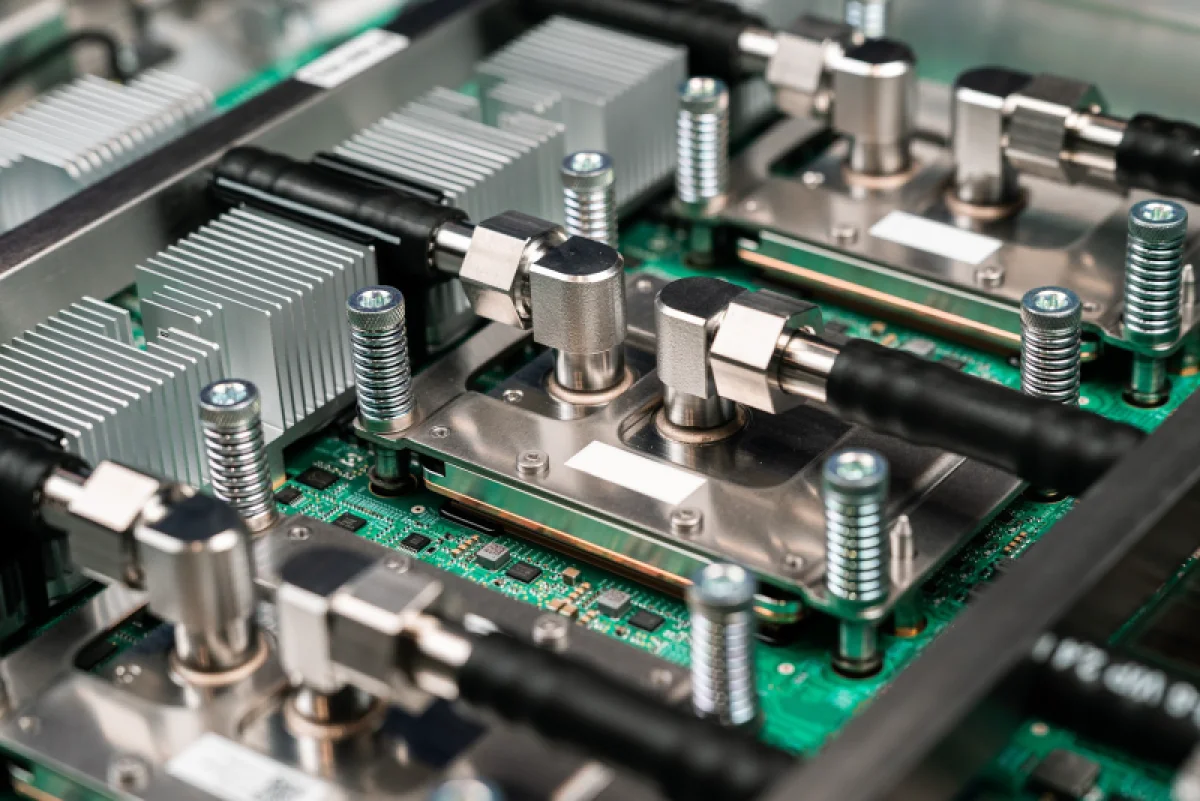

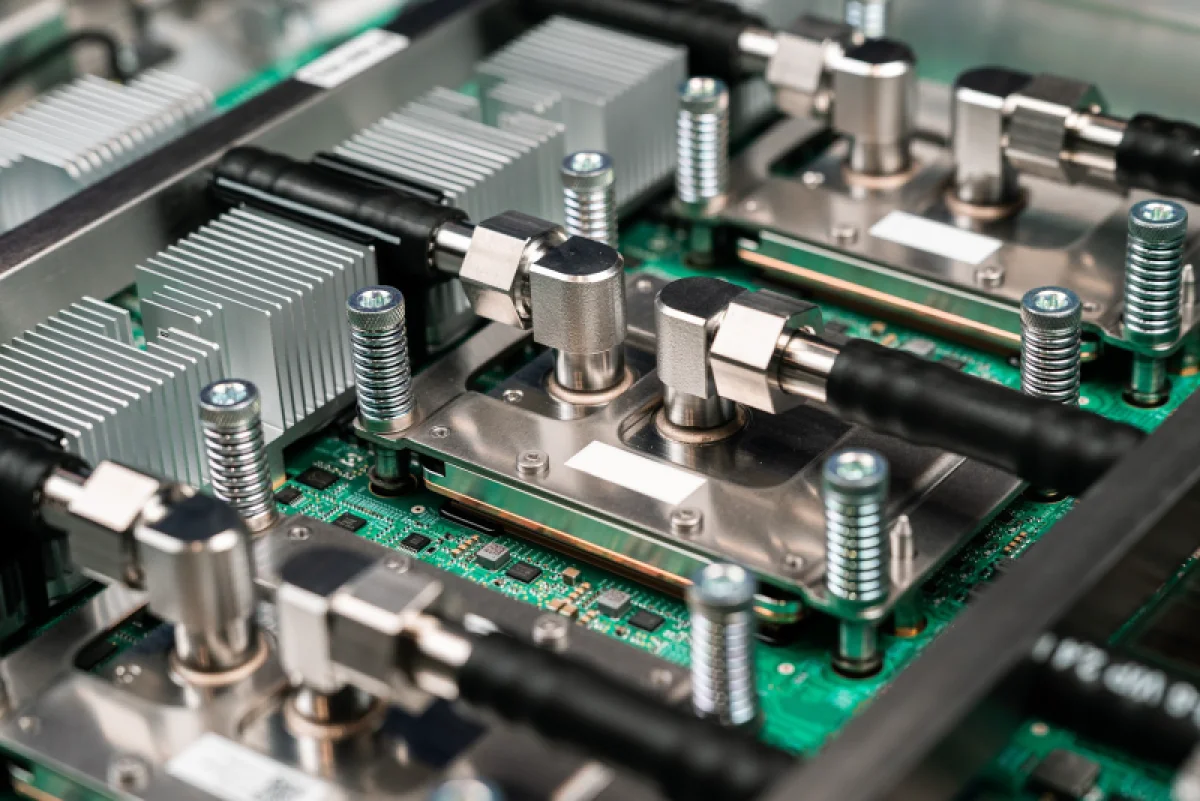

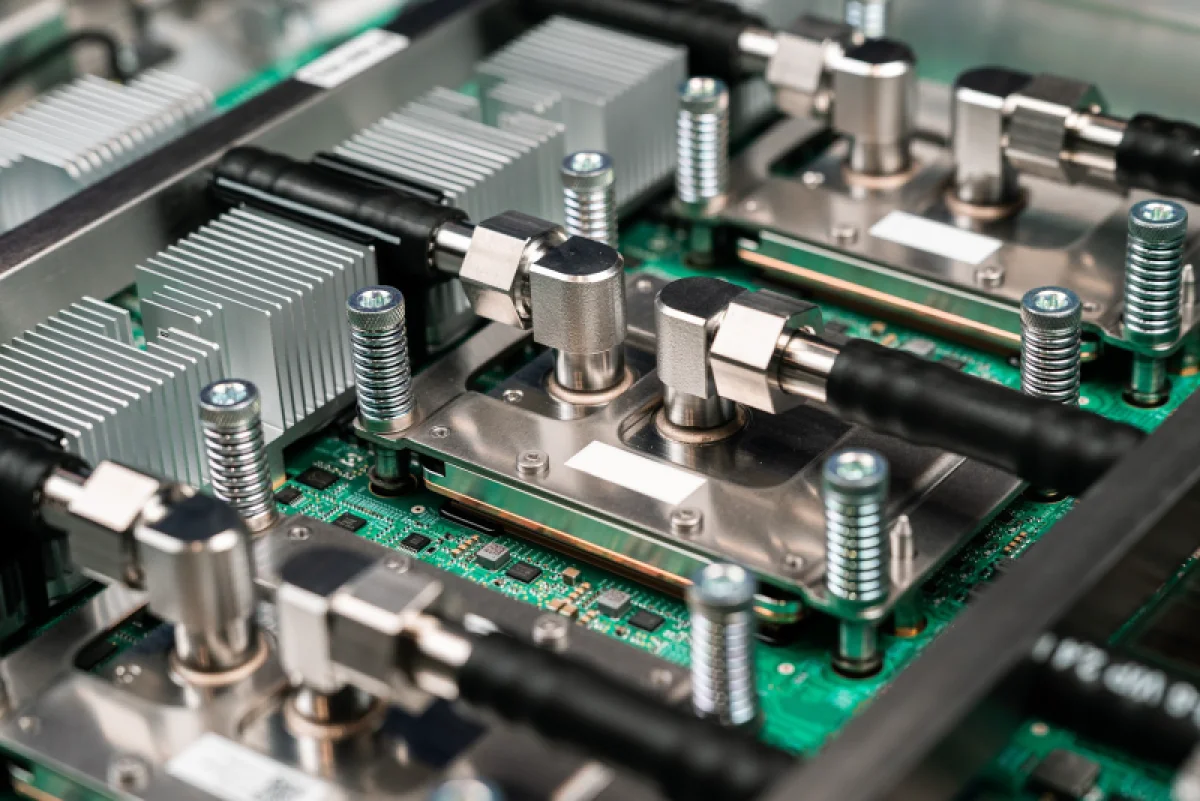

Источник изображений: Google

Презентация TPU Ironwood состоялась в апреле текущего года. Согласно данным Google, новое решение демонстрирует десятикратный прирост пиковой производительности относительно TPU v5p и более чем четырёхкратное улучшение производительности на чип в обучении и инференсе по сравнению с TPU v6e (Trillium), что делает Ironwood наиболее мощным и энергоэффективным специализированным чипом компании на сегодня.

Компания Google заявила, что архитектура Ironwood позволяет формировать вычислительные кластеры, объединяющие до 9216 процессоров (42,5 эксафлопс при работе с FP8), связанных межчиповой коммуникационной сетью (ICI) с пропускной способностью 9,6 Тбит/с и доступом к 1,77 петабайт общей памяти HBM, что устраняет ограничения при обработке информации даже самыми ресурсоёмкими моделями. В корпорации подчеркнули, что сервисы подобного уровня нуждаются в гарантированной бесперебойной работе. Эту задачу решает технология оптической коммутации (OCS), функционирующая как гибко перестраиваемая инфраструктура. При необходимости наращивания производительности система Ironwood способна масштабироваться до кластеров, объединяющих сотни тысяч TPU.

Для клиентов, применяющих решения на базе TPU, корпорация предоставляет инструмент Cluster Director в среде Google Kubernetes Engine. Это решение включает расширенные функции обслуживания и анализа топологии для интеллектуального распределения задач и построения высоконадёжных кластерных систем.

В области предварительного и посттренинга компания внедрила усовершенствования в MaxText — высокопроизводительную открытую платформу для больших языковых моделей, которые облегчают интеграцию передовых методик оптимизации обучения и обучения с подкреплением, включая контролируемую тонкую настройку (SFT) и оптимизацию политики генеративного подкрепления (GRPO) — алгоритм обучения с подкреплением (RL). Также расширена поддержка vLLM, что упрощает переход с GPU на TPU для задач вывода с минимальными доработками. А шлюз вывода GKE Inference Gateway способствует сокращению времени до генерации первого токена (TTFT).

Источник: